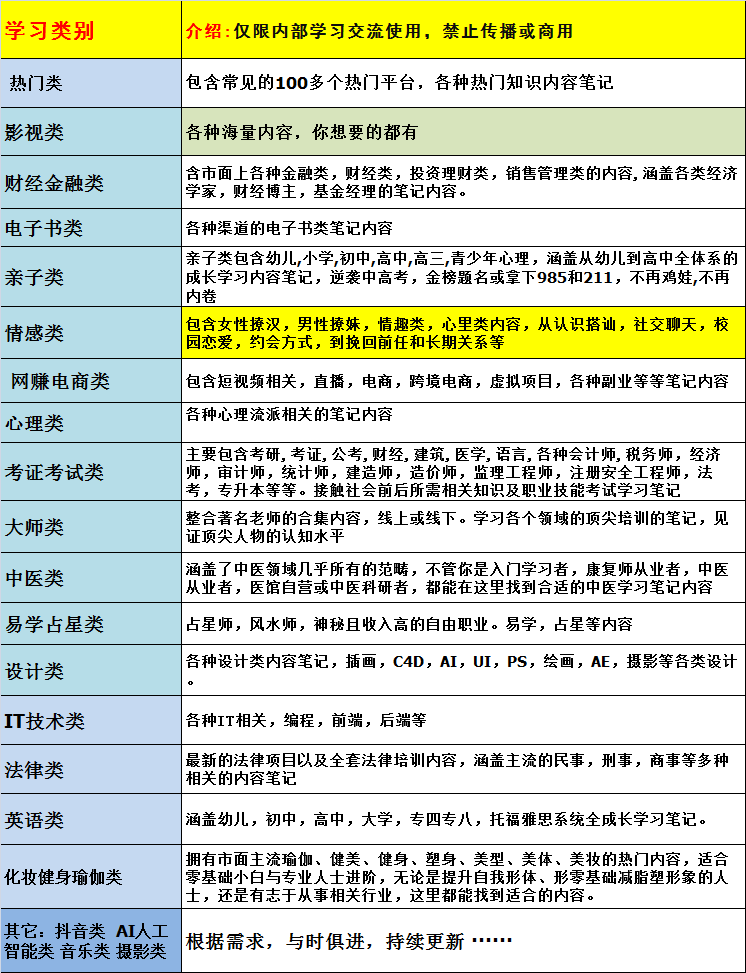

深度学习必修课进击算法工程师001.1-1课程内容和理念 002.1-2初识深度学习 003.1-3课程使用的技术栈 004.2-1线性代数 005.2-2微积分 006.2-3概率 007.3-1CUDAAnaconda深度学习环境搭建 008.3-2conda实用命令 009.3-3JupyterNotebook快速上手 010.3-4深度学习库PyTorch安装 011.4-1神经网络原理 012.4-2多层感知机 013.4-3前向传播和反向传播 014.4-4多层感知机代码实现 015.4-5回归问题 016.4-6线性回归代码实现 017.4-7分类问题 018.4-8多分类问题代码实现 019.5-1训练的常见问题 020.5-2过拟合欠拟合应对策略 021.5-3过拟合和欠拟合示例 022.5-4正则化 023.5-5Dropout 024.5-6Dropout代码实现 025.5-7梯度消失和梯度爆炸 026.5-8模型文件的读写 027.6-1最优化与深度学习 028.6-2损失函数 029.6-3损失函数性质 030.6-4梯度下降 031.6-5随机梯度下降法 032.6-6小批量梯度下降法 033.6-7动量法 034.6-8AdaGrad算法 035.6-9RMSProp_Adadelta算法 036.6-10Adam算法 037.6-11梯度下降代码实现 038.6-12学习率调节器 039.7-1全连接层问题 040.7-2图像卷积 041.7-3卷积层 042.7-4卷积层常见操作 043.7-5池化层Pooling 044.7-6卷积神经网络代码实现(LeNet) 045.8-1AlexNet 046.8-2VGGNet 047.8-3批量规范化 048.8-4GoogLeNet 049.8-5ResNet 050.8-6DenseNet 051.9-1序列建模 052.9-2文本数据预处理 053.9-3循环神经网络 054.9-4随时间反向传播算法 055.9-5循环神经网络代码实现 056.9-6RNN的长期依赖问题 057.10-1深度循环神经网络 058.10-2双向循环神经网络 059.10-3门控循环单元 060.10-4长短期记忆网络 061.10-5复杂循环神经网络代码实现 062.10-6编码器-解码器网络 063.10-7序列到序列模型代码实现 064.10-8束搜索算法 065.10-9机器翻译简单代码实现 066.11-1什么是注意力机制 067.11-2注意力的计算 068.11-3键值对注意力和多头注意力 069.11-4自注意力机制 070.11-5注意力池化及代码实现 071.11-6Transformer模型 072.11-7Transformer代码实现 073.12-1BERT模型 074.12-2GPT系列模型

深度学习必修课进击算法工程师001.1-1课程内容和理念 002.1-2初识深度学习 003.1-3课程使用的技术栈 004.2-1线性代数 005.2-2微积分 006.2-3概率 007.3-1CUDAAnaconda深度学习环境搭建 008.3-2conda实用命令 009.3-3JupyterNotebook快速上手 010.3-4深度学习库PyTorch安装 011.4-1神经网络原理 012.4-2多层感知机 013.4-3前向传播和反向传播 014.4-4多层感知机代码实现 015.4-5回归问题 016.4-6线性回归代码实现 017.4-7分类问题 018.4-8多分类问题代码实现 019.5-1训练的常见问题 020.5-2过拟合欠拟合应对策略 021.5-3过拟合和欠拟合示例 022.5-4正则化 023.5-5Dropout 024.5-6Dropout代码实现 025.5-7梯度消失和梯度爆炸 026.5-8模型文件的读写 027.6-1最优化与深度学习 028.6-2损失函数 029.6-3损失函数性质 030.6-4梯度下降 031.6-5随机梯度下降法 032.6-6小批量梯度下降法 033.6-7动量法 034.6-8AdaGrad算法 035.6-9RMSProp_Adadelta算法 036.6-10Adam算法 037.6-11梯度下降代码实现 038.6-12学习率调节器 039.7-1全连接层问题 040.7-2图像卷积 041.7-3卷积层 042.7-4卷积层常见操作 043.7-5池化层Pooling 044.7-6卷积神经网络代码实现(LeNet) 045.8-1AlexNet 046.8-2VGGNet 047.8-3批量规范化 048.8-4GoogLeNet 049.8-5ResNet 050.8-6DenseNet 051.9-1序列建模 052.9-2文本数据预处理 053.9-3循环神经网络 054.9-4随时间反向传播算法 055.9-5循环神经网络代码实现 056.9-6RNN的长期依赖问题 057.10-1深度循环神经网络 058.10-2双向循环神经网络 059.10-3门控循环单元 060.10-4长短期记忆网络 061.10-5复杂循环神经网络代码实现 062.10-6编码器-解码器网络 063.10-7序列到序列模型代码实现 064.10-8束搜索算法 065.10-9机器翻译简单代码实现 066.11-1什么是注意力机制 067.11-2注意力的计算 068.11-3键值对注意力和多头注意力 069.11-4自注意力机制 070.11-5注意力池化及代码实现 071.11-6Transformer模型 072.11-7Transformer代码实现 073.12-1BERT模型 074.12-2GPT系列模型

声明:本站大部分资源来源于网络,除本站组织的资源外,版权归原作者所有,如有侵犯版权,请立刻和本站联系并提供证据,本站将在三个工作日内改正。 本站仅提供学习的平台,将不对任何资源负法律责任,只作为购买原版的参考,并无法代替原版,所有资源请在下载后24小时内删除;资源版权归作者所有,如果您觉得满意,请购买正版。您若发现本站侵犯了你的版权利益,请来信本站将立即予以删除!